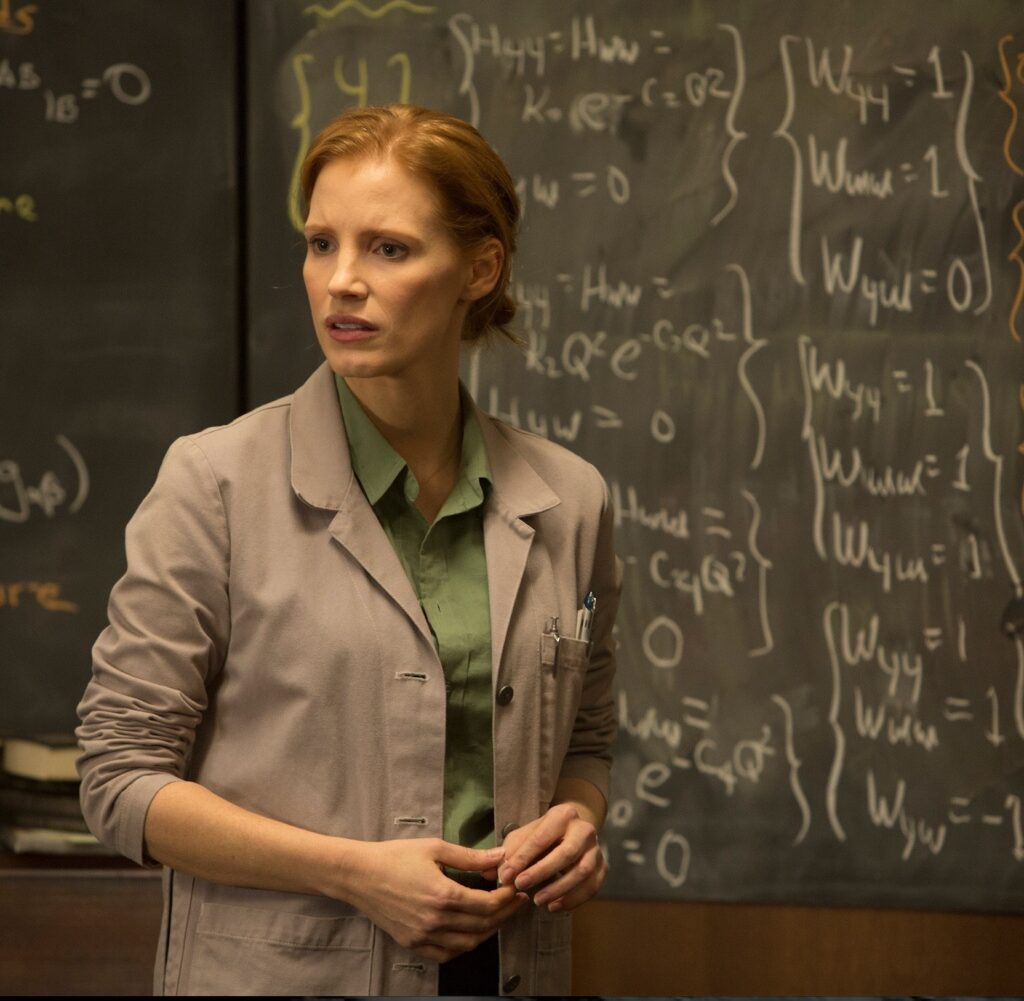

In una scena cruciale del film Interstellar Murph risolve alla lavagna le equazioni che unificano relatività generale e meccanica quantistica, un po’ il Santo Graal della scienza contemporanea. Le lavagne del Prof. Brand che si possono osservare in diverse scene del film sono sedici, e sono state scritte in realtà dal premio Nobel per la fisica del 2017 Kip Thorne. La figura che segue mostra Murch accanto a una di queste lavagne.

Le equazioni e le formule rappresentate fanno riferimento alla teoria delle Stringhe, e descrivono una teoria della gravità in un numero di dimensioni maggiori di quelle a cui siamo abituati, tre dimensioni spaziali e una temporale. Mostrano una rappresentazione di un buco nero in tre dimensioni spaziali, come sarebbe osservato da un “bulk” a quattro dimensioni spaziali. Nel film si narra di esseri che vivono in questo “bulk” penta-dimensionale (quattro dimensioni spaziali e una temporale), che si scopre alla fine del film essere una evoluzione futura del genere umano. Murph riesce nel film a trovare una soluzione delle equazioni e del problema approfittando dei suggerimenti del padre, che caduto in un tesseratto penta-dimensionale dentro un buco nero, capisce che l’unica maniera di comunicare l’informazione su come la fisica descrive la singolarità presente nel buco nero, e quindi la sua descrizione quantistica, è tramite un campo gravitazionale, con il quale trasmette il messaggio, facendo muovere le lancette del suo vecchio orologio nella libreria della stanza dove Murph sta cercando indizi. L’informazione trasmessa permette a Murph di capire come utilizzare le anomalie gravitazionali per ridurre l’intensità della forza gravitazionale, e permettere a gigantesche astronavi di lasciare la Terra morente, partire alla ricerca di una nuova Terra, il pianeta di Edmunds e salvare così il genere umano[1]. Nella realtà purtroppo ne Kip Thorne ne nessuno altro o altra sanno come risolvere le equazioni della gravità quantistica, anzi non siamo in grado oggi neanche di scriverle compiutamente queste equazioni. Ci vorrà ancora molto tempo e soprattutto molta immaginazione per risolvere i problemi della gravità multidimensionale e della gravità quantistica. Forse perché nessuno ha ancora avuto un genitore ingoiato da un buco nero. Thorne al pari di molti colleghi è ottimista: è inutile disperare, prima o poi ci arriveremo a risolvere l’enigma della gravità quantistica. E forse tra uno o due secoli scopriremo delle applicazioni utili e straordinarie della gravità quantistica e della teoria delle Stringhe. Non possiamo dire oggi a cosa possano servire queste teorie astruse, come nel 1850 non poteva dire Faraday al ministro britannico a cosa mai potesse essere utile l’elettricità. Oppure no?

Lo sviluppo della teoria delle Stringhe, una promettente strada per trovare una soluzione alla gravità quantistica, ha occupato migliaia di fisici, certamente la maggioranza dei fisici teorici, negli ultimi quaranta anni. Uno sforzo immane, che almeno come numero di addetti forse è confrontabile solo con il supporto dei fisici teorici al progetto Manhattan per lo sviluppo della bomba atomica o a quello che fu necessario per andare sulla Luna). Ma nonostante questo sforzo, non è chiaro oggi nemmeno se questa sia una teoria, se definiamo una teoria scientifica qualcosa che produce un insieme di equazioni che possono essere usate per produrre previsioni, o comunque delle istruzioni per spiegare quello che la teoria vuole descrivere. La teoria delle Stringhe prevede l’esistenza di ben 10 dimensioni spaziali e una temporale, e si basa sulla supersimmetria, un ampliamento naturale del così detto Modello Standard delle particelle elementari. La supersimmetria è un’idea bellissima, sviluppata negli anni 70’, per la quale per ogni particella dovrebbero esistere dei partners, appunto supersimmetrici. I partners supersimmetrici dei ferminioni (i protoni e gli elettroni di cui siamo formati), sarebbero bosoni, e cioè i portatori delle forze conosciute, e viceversa. Purtroppo ad oggi, nonostante una ricerca molto lunga e puntigliosa, nessuna particella supersimmetrica è stata scoperta né da LHC né in tutti gli altri acceleratori di particelle.

La teoria delle Stringhe accomoda in maniera naturale una inflazione caotica, dove il momento di crescita esponenziale dell’Universo non è accaduto solo una volta, subito dopo il big-bang, ma avviene praticamente sempre in regioni di spazio differenti e a tempi differenti. Questa moltiplicazione di universi-bolla costituisce il multiverso previsto dalla teoria delle Stringhe. Nel 2015 gli esperimenti BICEP2 e Keck, combinati con i dati di Planck, hanno raggiunto una sensibilità tale da escludere le grandi scale di energia per l’inflazione che sono tipiche di una inflazione caotica[2]. Se una inflazione c’è stata, probabilmente non è il modello semplice immaginato da Linde nel 1986 e ripreso dalla teoria delle Stringhe nell’ambito del multiverso. Una ulteriore fase di miglioramento della strumentazione BICEP e Keck si sta concludendo proprio in questi mesi, e nei prossimi pochi anni i limiti sulla scala di energia dell’inflazione saranno migliorati di un fattore 10-20 rendendo possibile la conferma o il rifiuto di forme di inflazione ritenute oggi come le più probabili come l’inflazione di Starobinsky o quella prodotta eventualmente dal bosone di Higgs.

La mancata verifica sperimentale di predizioni della teoria delle Stringhe, o comunque di alcune delle sue aspettazioni, potrebbe semplicemente essere un problema contingente, magari tra pochi anni una particella supersimmetrica potrebbe emergere nei run di LHC o di qualche altro acceleratore di particelle, o meglio ancora l’evidenza di nuove dimensioni dello spazio. Oppure la teoria delle Stringhe potrebbe semplicemente essere sbagliata. Dopo tutto l’insieme delle teorie sbagliate è sicuramente molto più grande di quello delle teorie giuste.

Nel 2006 Lee Smolin scriveva: “la nostra comprensione delle leggi della natura ha continuato a crescere rapidamente per oltre due secoli, ma oggi, nonostante tutti i nostri sforzi di queste leggi non sappiamo con certezza più di quanto ne sapessimo negli anni 70’. Sono passati tre decenni senza progressi cruciali nella fisica fondamentale” [3]. Se consideriamo come cruciali i progressi in fisica fondamentale quelli basati su verifiche sperimentali, a cavallo del cambio di secolo ce ne sono stati almeno due: la scoperta che l’Universo sta accelerando la sua espansione, e la alla scoperta che i neutrini hanno massa. Perché i neutrini debbano avere una massa, e quale sia la causa dell’espansione accelerata dell’Universo, una forma di energia oscura, o una costante cosmologica, non sappiamo ancora dire. Negli ultimi quattro anni abbiamo assistito un’altra scoperta fondamentale, la rivelazione di onde gravitazionali da parte di buchi neri e stelle di neutroni che si fondono assieme dopo aver ruotato freneticamente uno attorno all’altro. Non a caso queste tre scoperte hanno prodotto altrettanti premi Nobel.

Smolin confrontava questo trentennio con quello agli inizi del 1900, nel quale vennero sviluppate le due teorie fondamentali che hanno prodotto come abbiamo visto la grande maggioranza del nostro progresso tecnologico: la meccanica quantistica e la relatività (speciale e generale). Dal 2006 è passato un altro decennio e la situazione non è migliorata di molto. Nel 2012 dopo una lunga ricerca il bosone di Higgs è stato individuato in maniera incontrovertibile nei dati di Atlas e CMS a LHC, ma questa scoperta non ha aperto a nuova fisica, ha solo completato il Modello Standard per la fisica delle particelle, sviluppato nel decennio 1960-1970. Nel 2006 Smolin indicava cinque grandi problemi nella fisica teorica che non erano ancora stati risolti: i. la gravità quantistica; ii. i fondamenti della meccanica quantistica; iii una teoria che unifichi le particelle e le forze; iv. Come sono scelti dalla natura i tanti parametri liberi del modello standard, da dove arrivano le masse delle particelle elementari; v. spiegare la materia oscura e l’energia oscura che costituiscono la gran parte (>95%) della materia/energia dell’Universo, oppure, se non esistono, spiegare come e perché la gravità si modifica su grandi scale, suggerendo la presenza di materia ed energia oscure. Tredici anni dopo la nostra comprensione di questi problemi non ha fatto grandi passi avanti. Il che porta a più di quattro i decenni senza progressi fondamentali nella fisica teorica. Che ci sia un problema sembra evidente. Le radici di questo problema potrebbero essere tante. Da quelle di sostanza, abbiamo in qualche modo saturato la capacità di progredire in fisica fondamentale, vuoi perché è difficile avere nuovi dati sperimentali (nuove particelle potrebbero esistere ed emergere ad energie sostanzialmente non raggiungibili da esperimenti concedibili oggi), vuoi perché le teorie fondamentali potrebbero essere così complicate da non essere affrontabili dalla presente generazione di fisici e da quelle nel prossimo futuro. A quelle sociologiche, e di politica della scienza. Il questo caso, il problema potrebbe essere in qualche modo connesso a quello che discutevamo nel capitolo precedente. Come nel caso della Big Science, la scienza che rischia di diventare troppo grande fagocitando tutto il resto, è possibile che mettere la maggior parte delle risorse nello stesso paniere in fisica teorica non sia stata una scelta troppo felice. Tornerò su questo punto anche nel seguito.

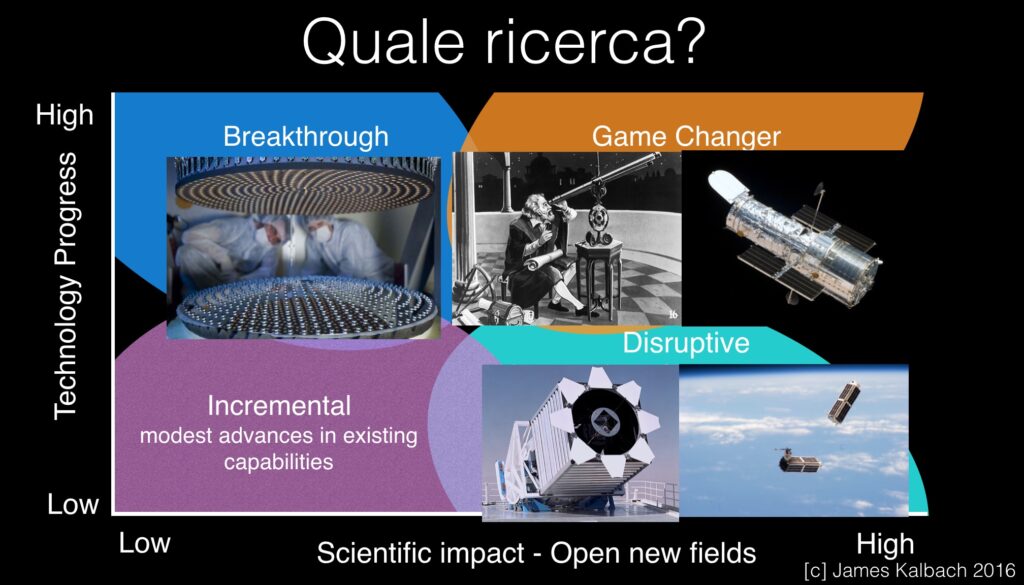

È arrivato il momento di affrontare una delle domande centrali che questo libro vuole discutere: quale e quanta ricerca è davvero utile? E come possiamo fare a capire, almeno in prima approssimazione quale scienza è utile e quale no? Per affrontare questo tema è comodo utilizzare uno schema mutuato da quello inventato da Jim Kalbach per rappresentare in maniera bidimensionale l’innovazione. Nell’originale, l’asse orizzontale rappresenta l’impatto sul mercato di una determinata tecnologia, e serve a misurare il grado di innovazione di nuovi prodotti. Nella mia applicazione, ho semplicemente sostituito impatto sul mercato con impatto scientifico, capacità di aprire nuovi campi. Il diagramma di Kalbach e’ diviso in quattro zone:

Progresso Incrementale: cambiamenti modesti nella tecnologia che mantengono un bussines (o un prodotto scientifico) competitivo.

Breaktrough: grandi avanzamenti tecnologici che però non hanno ancora prodotto un impatto analogamente forte sul mercato (o in un campo scientifico).

Game changer: un avanzamento tecnologico talmente grande da produrre un impatto radicale, tanto da trasformare il mercato (o aprire nuovi campi scientifici) e addirittura la società.

Disruptive: l’utilizzo di tecnologie che offrono prestazioni mediocri, ma che sono lo stesso in grado di trasformare il mercato (o aprire nuovi campi scientifici).

Esempi classici di tecnologie associate alle zone breakthrough, game changer, e disruptive sono rispettivamente: il motore a scoppio, quando venne inventato fu un enorme avanzamento, ma non cambiò il modo di viaggiare della gran parte della gente, perché costava troppo. Il cambiamento epocale avvenne con l’invenzione della catena di montaggio da parte di Ford, che rese di colpo accessibili le automobili a una enorme platea. Tecnologie breakthrough possono quindi trasformarsi in game changer, una volta che il loro impiego sia generalizzato e accessibile a una grande platea. Esempi di tecnologie disruptive sono i laptop e gli smartphones. I primi funzionano peggio di un desktop ma hanno l’enorme vantaggio di poterseli portare appresso sostanzialmente ovunque. I secondi riuniscono in un unico dispositivo tante funzioni, per ognuna delle quali lo smartphone funziona peggio del dispositivo dedicato, ma lo smartphone ha l’enorme vantaggio appunto di poter fare innumerevoli cose (telefonare, accedere ad internet, fotografare, riprodurre musica, localizzare etc. etc. etc.).

Se applichiamo questo diagramma alla scienza possiamo catalogare allo stesso modo le tecnologie e le scoperte scientifiche nelle quattro zone, come nella figura che segue.

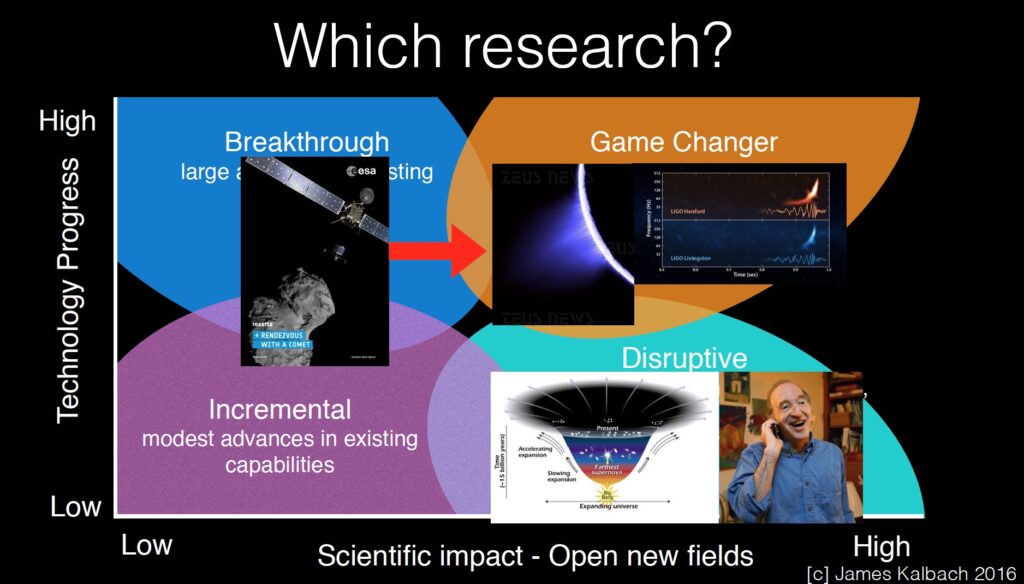

L’utilizzo del cannocchiale da parte di Galileo sicuramente è stato un punto di svolta, che non ha solo cambiato la nostra visione dell’Universo, ma anche il modo di pensare e di fare scienza, e di conseguenza anche la società. Mutatis mutandis un ruolo analogo l’ha svolto l’Hubble Space Telescope (HST), o più recentemente gli interferometri gravitazionali Ligo e Virgo, che hanno creato un nuovo campo di investigazione, che semplicemente prima non c’era: l’astrofisica multi-messaggera. Un esempio di tecnologie breakthrough è la così detta ottica adattiva (AO), sistemi che riescono a correggere automaticamente le aberrazioni indotte dall’atmosfera terrestre nella formazione di immagini di sorgenti celesti. Questi sistemi complessi sono oggi in grado di produrre immagini più acute di quelle prodotte da HST, ma non sono ancora di uso semplice, e quindi comune. È probabile che l’ottica adattiva diventi una tecnologia game changer una volta che sarà sistematizzato il suo uso, e soprattutto l’analisi relativa dei dati, con l’avvento dei telescopi di prossima generazione come l’E-ELT. Infine un esempio di tecnologie Disruptive è l’utilizzo del telescopio da 2.5m posto ad Apache Point Observatory, con cui si conduce la Sloan Digital Sky Survey. Il diametro di questo telescopio è esattamente quello dell’HST, ma il suo costo è un fattore >10.000 volte minore. Nondimeno, la produttività in termini di articoli di SDSS è maggiore di quella di tutti i telescopi esistenti, incluso HST. Una potenziale tecnologia Disruptive è quella dei Cubesat dedicati a misure scientifiche. Cubesat sono nano-satelliti del peso di qualche kg, in grado di ospitare quindi strumenti solo molto semplici. Il costo di un cubesat è però enormemente minore di quello delle sonde spaziali che oggi gli scienziati utilizzano per studiare l’Universo, e il loro tempo di sviluppo è di solo qualche anno, contro i decenni delle normali missioni spaziali. Costi ridotti e rapidi tempi di sviluppo offrono opportunità uniche, come quelle di evitare i rischi connessi con il lancio di satelliti altamente performanti ma unici tramite la ridondanza, la capacità di verificare il funzionamento in orbita di uno strumento ed eventualmente migliorarlo prima di lanciare il seguente satellite. Infine, il breve tempo di sviluppo permette ai ricercatori e agli studenti coinvolti di seguire tutte le fasi di sviluppo del progetto, dall’ideazione al disegno alla realizzazione dell’hardware e del software, alle operazioni e infine all’analisi dei dati. Tutto questo bagaglio risulta fondamentale nel processo di crescita degli studenti e dei giovani ricercatori.

Facendo un ulteriore passo, possiamo pensare di collocare nel diagramma di Kalbach anche le scoperte scientifiche, come nella figura che segue.

7.1 La nascita dell’astrofisica multi-messaggera

Martedì 16 settembre 2015 un alert ha fatto il giro del mondo, finendo negli smartphone e nei computers delle molte decine di astrofisici che avevano firmato un Memorandum of Understanding con la collaborazione LIGO/Virgo per il follow-up di eventi di rivelazione di onde gravitazionali con telescopi che potevano effettuare osservazioni in tutta la banda dello spettro elettromagnetico, dalle onde radio ai raggi gamma. Il messaggio automatico riportava una possibile rivelazione di un segnale da parte degli interferometri gravitazionali LIGO, avvenuto un paio di giorni prima, alle 9 del mattino di domenica 14 settembre. Il messaggio arrivava abbastanza inaspettato, perché’ gli interferometri avevano appena ripreso le osservazioni dopo un lungo periodo di manutenzioni e migliorie. Anzi, per quanto se ne sapeva la ripresa dati, un periodo chiamato in gergo O1, sarebbe dovuto cominciare il 15 settembre, mentre l’evento sembrava essersi verificato il giorno prima. Evidentemente i test ingegneristici sui due interferometri di Hardford nello stato di Washington, e di Livingstone in Luisiana erano andati meglio del previsto e le prese dati vicine alla sensibilità aspettate erano potute cominciare con qualche anticipo. Dopo le migliorie che erano state apportate sugli strumenti, la sensibilità avrebbe dovuto migliorare di un fattore tra 3 e 10 a seconda della frequenza del segnale rispetto agli strumenti che avevano funzionato nel primo decennio degli anni 2000. Siccome la risposta dei rivelatori è proporzionale all’ampiezza del segnale, il volume di spazio a cui i rivelatori sono sensibili incrementa con il cubo della sensibilità. I miglioramenti apportati quindi corrispondevano a un volume di ricerca tra 10 e 1000 volte maggiore di quello accessibile alla strumentazione precedente, e che non aveva portato a rivelazioni statisticamente significative di segnali di onde gravitazionali. Possibile che appena accesi gli interferometri avessero visto quel segnale atteso invano da più di trenta anni? Cioè da quando i progetti Ligo e Virgo vennero ideati e proposti negli Stati Uniti e in Italia e Francia durante gli anni 80’ e poi realizzati durante gli anni 90’.

Il messaggio arrivato sullo smartphone conteneva il tempo d’arrivo del segnale e la zona di cielo da cui probabilmente proveniva. Questa zona era decisamente molto ampia, un migliaio di gradi quadri, ed era il bersaglio delle attività che gli astrofisici avrebbero dovuto far partire rapidamente. Osservare questa zona di cielo alla ricerca di un segnale elettromagnetico, una sorgente di luce transiente, che potesse eventualmente essere associato al segnale gravitazionale. La collaborazione GRAWITA aveva accesso a diversi telescopi in Italia, e soprattutto a un potente telescopio proprio dedicato a scansioni di grande campo del cielo, il VST in Cile.

Le informazioni che trapelavano dalla collaborazione LIGO/Virgo non erano state per questo primo evento troppo accurate né molto tempestive. Evidentemente anche la grande collaborazione era stata presa un poco di sorpresa dall’evento. Le analisi per validare la correttezza della rivelazione e per derivare le informazioni sulla sorgente di onde gravitazioni erano complesse, e comprensibilmente la collaborazione voleva effettuare tutti i controlli necessari prima di annunciare una scoperta che avrebbe cambiato il modo stesso di fare astrofisica, di osservare l’Universo. Gli alert servivano ad attivare prima possibile le ricerche di segnali in luce visibile che avrebbero potuto essere associati all’evento di onde gravitazionali. I nuovi interferometri gravitazionali stavano cominciando a permettere, per la prima volta nella storia l’Uomo, l’osservazione di sorgenti celesti utilizzando un messaggero diverso dalla luce, le onde gravitazionali, piccole increspature dello spazio-tempo prodotte da eventi parossistici di altissima energie e che si propagavano nello spazio-tempo, come le onde prodotte da un sasso sulla superficie di un laghetto, ad una velocità che si presume essere quella della luce stessa. La collaborazione GRAWITA aveva cominciato subito a raccogliere dati, al pari di molte altre collaborazioni in giro per il mondo. Questa prima ricerca purtroppo non produsse l’identificazione di una probabile controparte “elettromagnetica” dell’evento di onde gravitazionali (quella che chiamiamo luce non è altro che la propagazione di un campo elettromagnetico), nondimeno era nata l’astrofisica multi-messaggera.

La prima rivelazione della storia di onde gravitazionali venne annunciata pubblicamente molti mesi dopo, in una conferenza stampa l’11 febbraio 2016. Si trattava delle onde gravitazionali prodotte durante coalescenza di due buchi neri di masse di circa 30 e 35 masse Solari rispettivamente, che dopo l’impatto avevano prodotto un singolo buco nero di circa 62 masse solari. Le circa 3 masse solari che mancavano all’appello erano appunto state emesse sotto la forma di onde gravitazionali. Utilizzando la famosa formula di Einstein E=Mc2 dove c è la velocità della luce nel vuoto, circa 300.000 km/s, questa massa corrisponde ad una energia gigantesca, circa 10^55 ergs, tra 1000 e 10000 volte maggiore dell’energia associata alle più grandi esplosioni cosmiche come le Supernovae e i Gamma Ray Bursts (o pari all’energia emessa da tutte le stelle della nostra galassia, circa 100 miliardi, per circa 3000 anni). Quello che era successo è grossolanamente descritto da quello che segue. Due buchi neri di massa molto grande (per gli standard stellari) facevano parte di un sistema binario, orbitando uno attorno all’altro. Durante il moto orbitale il sistema aveva perso energia sotto forma di onde gravitazionali, e perdendo energia le orbite erano diventate sempre più strette e il moto dei buchi neri sempre più veloce, aumentando di conseguenza la perdita di energia e così via, fino al momento in cui i due buchi neri erano venuti a contatto, e avevano formato un singolo oggetto, che dopo una frazione di secondo si era assestato formando il buco nero finale di 62 masse solari. Il segnale rivelato copriva l’ultima frazione di secondo dell’evoluzione del sistema, subito prima del contatto e durante la fase di assestamento. Questa osservazione, che conferma le predizioni della teoria della relatività generale di Einstein, è stata premiata con il premio Nobel in Fisica nel 2017 a Kip Thorne, Rainer Weiss e Barry Barish, i primi due tra gli ideatori di LIGO negli anni 80’ e il terzo il corrente responsabile di LIGO. Il terzo tra gli ideatori di LIGO, Ronald Drever purtroppo è deceduto il 7 marzo 2017, prima di poter essere insignito del premio Nobel.

Nessun segnale elettromagnetico è stato associato all’evento gravitazionale del 14 settembre 2015, ne ai successivi eventi di coalescenza di due buchi neri trovati nel corso del 2015, 2016 e 2017. Da un lato le regioni di cielo da cui i segnali provenivano erano state determinate con scarsa accuratezza, perché’ i primi eventi gravitazionali erano stati rivelati solo dai i due interferometri americani. Dall’altro lato, non ci si aspettano segnali elettromagnetici potenti a causa della coalescenza di due buchi neri. Il motivo è che il motore per produrre un qualche segnale elettromagnetico ha probabilmente bisogno di una relativamente grande quantità di materia convenzionale a disposizione. In un buco nero tutta la materia è confinata all’interno dell’orizzonte degli eventi, e non può interagire o mandare segnali ad osservatori all’esterno di questo orizzonte. Quando due buchi neri coalescono, l’orizzonte degli eventi semplicemente si ingrandisce a comprendere tutta la materia di cui sono composti i buchi neri, eccetto quella parte che viene liberata sotto forma di energia delle onde gravitazionali. Diverso è il caso in cui a coalescere sono due stelle di neutroni o una stella di neutroni e un buco nero. In questi casi materia convenzionale, anche se in stati ultra-densi di cui sappiamo davvero poco, può essere presente all’esterno del buco nero, e formare un massiccio disco di accrescimento. Questo disco di materia può liberare la sua grande energia gravitazionale lanciando potenti jet a velocità vicine a quelle della luce. Nei jet è molto plausibile aspettarsi efficiente accelerazione di particelle e quindi emissione di luce sotto forma di raggi X e gamma, in presenza di un anche piccolo campo magnetico. In effetti, modelli di coalescenza di stelle di neutroni prevedevano associati Gamma Ray Burst corti, che, come dice la parola, sono potentissimi burst di raggi gamma della durata tra qualche millisecondo e qualche secondo. Questo è quello che si è effettivamente verificato il 17 agosto 2017. Alle 12:41 gli interferometri LIGO e Virgo hanno rivelato un potente segnale gravitazionale che è durato una decina di secondi e al quale è seguita, dopo circa 1,7 secondi, la rivelazione di un Gamma Ray Burst corto da parte dei satelliti Fermi e INTEGRAL. Quella che prima era una inferenza, una aspettazione di un modello, si era trasformata in una osservazione,

abbiamo visto un GRB corto associato alla coalescenza di due stelle di neutroni, abbiamo davvero osservato lo stesso evento sia utilizzando la luce, la radiazione X e gamma, che le onde gravitazionali. La regione di cielo da cui i segnali si originavano è stata vincolata con una accuratezza molto migliore di quella dei primi eventi gravitazionali, sia grazie alla presenza di un terzo interferometro gravitazionale in funzione, Virgo, vicino Pisa, sia incrociando il box di errore di LIGO/Virgo con quelli di Fermi e INTEGRAL. La dimensione della regione che doveva comprendere la sorgente di onde gravitazionali e raggi X e gamma, il box di errore, era di solo una trentina di gradi quadrati. Poi, l’ampiezza del segnale gravitazionale è proporzionale sia alle masse degli oggetti in gioco che alla distanza dell’evento. Le masse degli oggetti possono essere stimate dalla frequenza del segnale, così da poter avere una informazione diretta sulla distanza dell’evento. Il caso di 17 agosto 2017 è stato particolarmente fortunato, perché’ la distanza è risultata particolarmente piccola, solo una quarantina di Mpc. Fino a questa distanza nei 30 gradi quadri del box di errore sono presenti solo una cinquantina di galassie. È stato quindi relativamente facile osservarle tutte per vedere se per caso in qualcuna si fosse attivata una sorgente transiente in luce ottica. E in effetti una nuova sorgente ottica è stata trovata subito nei dintorni della galassia NGC4993. Questa sorgente è stata osservata da una flotta imponente di telescopi sia a terra che nello spazio, in tutto più di 70 telescopi, sensibili alla luce dalle radio onde alla luce ottica, ai raggi X. La nuova sorgente ottica come prevedevano i modelli era una così detta kilonova, alimentata dal decadimento radioattivo dei nuclei pesanti sintetizzati nella regione subito esterna alla coalescenza delle stelle di neutroni. Queste stelle sono composte come il nome suggerisce da materia ad altissima densità[4] composta per lo più da neutroni e nuclei di metalli pesanti come il ferro. La maggior parte della materia che costituiva le due stelle di neutroni coalesce a formare un buco nero, ma una frazione rimane all’esterno dell’orizzonte degli eventi, in strutture come dischi di accrescimento e venti. A causa dell’altissima densità neutronica in queste strutture, è probabile che nuclei pesanti catturino neutroni, e diventino instabili per decadimento radioattivo. La radiazione prodotta è quella che è stata osservata in ottico e nel vicino infrarosso. In questi venti vengono quindi sintetizzati elementi pesanti in maniera efficiente. Si pensa che la maggior parte degli elementi più pesanti del ferro, tra cui l’oro, vengano in effetti sintetizzati nelle kilonovae. Da cui i titoli sui giornali, che appunto riportavano della scoperta come quella delle fabbriche cosmiche di oro e altri materiali preziosi. Di nuovo, un modello si è trasformato in una osservazione grazie alla nascente astrofisica multi-messaggera. Ma c’è anche di più. Il segnale gravitazionale dipende anche dall’inclinazione del sistema binario lungo la linea di vista. Nel caso dell’evento del 17 agosto 2017 l’inclinazione derivata dal segnale gravitazionale era di circa 20 gradi. Come abbiamo ricordato in precedenza alla coalescenza di due stelle di neutroni può seguire un GRB corto, provocato da emissione gamma nel jet formato a seguito dell’accrescimento di materia sul buco nero appena formato. La materia nel jet viaggia a velocità relativistiche e questo provoca il così detto beamingrelativistico dell’emissione prodotta. In parole povere, i fotoni emessi quando la materia viaggia a velocità relativistiche sono concentrati lungo la direzione di propagazione della materia, così che il flusso intercettato da un osservatore a cui capiti di guardare il jet giusto di faccia viene grandemente amplificato rispetto a quello isotropico, luce che viaggia in tutte le direzioni, che si avrebbe per sorgenti a bassa velocità. Più veloce è la materia più grande è il beaming relativistico. Le luminosità dei GRB (flusso osservato per distanza a quadrato), sono quindi generalmente enormi. Non quella del GRB 170817, che risultò essere circa 100 volte più bassa di quella del GRB corto meno luminoso mai osservato. Come mai? La soluzione più naturale è che nel caso di GRB170817 non abbiamo osservato il jet di faccia, ma con una inclinazione di circa 20 gradi. A questo angolo la velocità della materia nel jet è ridotta rispetto a quella nel core del jet, e di conseguenza è ridotto di beaming relativistico. Questa inferenza è stata poi confermata da osservazioni radio che hanno misurato una grandezza della sorgente esattamente consistente con quella che ci si aspetta per un jet visto a circa 20 gradi di angolo. Ho citato solo alcune delle scoperte fondamentali che sono state possibili grazie alla rivelazione congiunta in onde gravitazionali e luce dell’evento del 17 agosto 2017. E queste sono state possibili grazie ad un solo evento. L’astrofisica multi-messaggera è nella sua infanzia, ha già prodotto risultati sensazionali, ma certamente molte eccitanti scoperte e magari qualche sorpresa ci aspettano nel prossimo futuro. Ho detto che non ci aspettiamo segnali elettromagnetici dalla coalescenza di due buchi neri, e proprio per questo motivo trovarne invece traccia sarebbe eccezionalmente eccitante e importante, perché’ aprirebbe la possibilità di scenari e di fisica che oggi neanche siamo in grado di immaginare. Per tutti i motivi che ho cercato di spiegare a mio parere l’astrofisica multi-messaggera fa parte di quelle poche scoperte che sono veramente game-changer.

7.2 La scoperta di molecole prebiotiche nella cometa Churymov-Gerasimenko

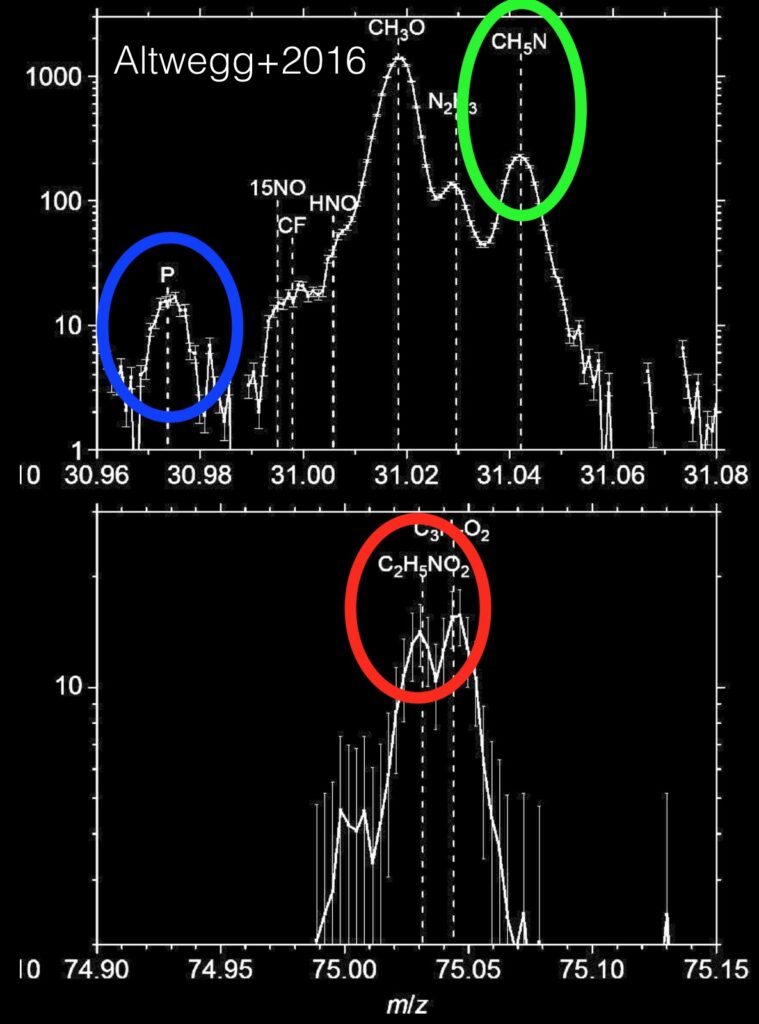

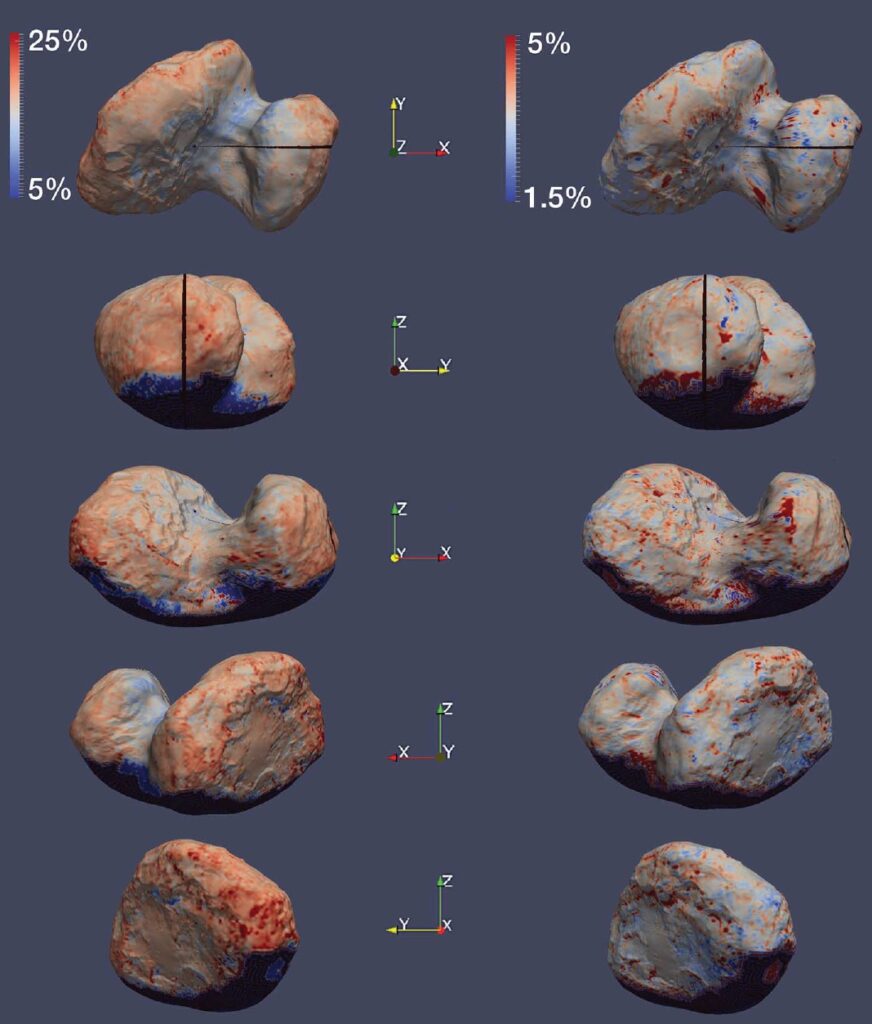

Due delle scoperte più importanti della missione Rosetta dell’Agenzia Spaziale Europa sono stata certamente la presenza di molecole prebiotiche e di fosforo nella coda della cometa[5] e la scoperta che la cometa è completamente coperta di materiale organico[6]. Circa la prima, la coda della cometa è stata osservata dallo spettrometro di massa ROSINA, che ha individuato tra gli elementi volatili la presenza di methylamina e ethylamina, due molecole prebiotiche di cui sono composti gli aminoacidi (vedi figura qui sotto). Gli aminoacidi sono le molecole di cui sono composte le proteine, e in particolare tutte le proteine che conosciamo sulla terra sono composte da venti aminoacidi. ROSINA ha quindi identificato nella coda della cometa la presenza di Glycine, il più leggero degli aminoacidi, in forma volatile e infine, è stato trovato anche molto fosforo. Il fosforo è un elemento cruciale per la chimica della vita, dato che è presente nello scheletro del DNA e nella molecola ATP (Adenosine Tri Phosphate), che è fondamentale per la produzione di energia nelle cellule e quindi in tutti gli esseri viventi. Allo stesso tempo, ci si era resi conto che la cometa era completamente ricoperta di materiale organico. I “colori” della superficie cometaria in luce ottica e nel vicino infrarosso (in realtà gli indici spettrali, cioè una misura della pendenza degli spettri ottici e infrarossi, sono compatibili con quelli aspettati da minerali piuttosto opachi associati a macro-molecole organiche di composizione complessa, a base carbonio-idrogeno e/o ossigeno-idrogeno, esattamente la composizione delle molecole prebiotiche identificate da ROSINA come volatili nella coda della cometa.

La naturale inferenza che si può far discendere da queste due scoperte è che il suolo della cometa debba essere ricco di molecole prebiotiche, e forse anche di aminoacidi più complessi e pesanti del Glycine. E proprio scoprire molecole prebiotiche complesse era l’obiettivo principale della sonda Phillae, che staccatasi da Rosetta avrebbe dovuto posarsi gentilmente sulla cometa, ed effettuare analisi in situ. Come sappiamo la sonda è effettivamente riuscita ad “accometare” ma purtroppo non è riuscita ad ancorarsi solidamente sulla superficie della cometa, e dopo qualche rimbalzo è andata ad incastrarsi in un crepaccio. Il trapano, ideato e costruito in Italia dal Politecnico di Milano, che doveva perforare la superficie della cometa, ed estrarre campioni da far analizzare allo spettrometro di massa COSAC (COmetary SAmpling and Composition Experiment, con il compito di rilevare e identificare molecole organiche complesse), è uscito come previsto dal suo alloggiamento, ma purtroppo non ha trovato il suolo. E quindi non è stato possibile portare a termine questo esperimento cruciale.

La scoperta di molecole prebiotiche volatili e di fosforo nella coda della cometa Churymov-Gerasimenko da parte della sonda ESA Rosetta appartiene a mio parere alla classe dei breakthrough, perché il test cruciale, la presenza di aminoacidi e altre molecole prebiotiche complesse sulla superfice della cometa, non è stato potuto effettuare da Phillae. Oggi ancora supponiamo, ma non sappiamo per certo se i mattoni della vita siano presenti sulle comete, e se questi siano riusciti a formare strutture ancora più complesse, proteine o addirittura frammenti di RNA, in un ambiente così ostile come lo spazio. E’ evidente che scoprire tracce di vita nello spazio, su una cometa o altrove, sarà un game changer, una scoperta che avrà un impatto profondo e radicale non solo sulla scienza, ma su tutta la società. Un evento che per alcuni è scontato, non si tratta di scoprire se c’è vita altrove nello spazio, ma solo di capire fino a che punto la vita si sviluppa in ambienti cosmici. Mi piace ricordare quello che scrive il premio Nobel Christian De Duve: “I mattoni della Vita si formano naturalmente nella nostra Galassia, e probabilmente anche altrove nel cosmo. I semi chimici della vita sono Universali[7]. E ancora: “La Vita è una manifestazione obbligatoria della materia, è codificata nella trama stessa dell’Universo[8]. Rosetta e Phillae non sono riusciti, ma davvero per poco, ad innescare questa rivoluzione. Ci proverà nel prossimo futuro una missione che la NASA sta studiando. Una missione che ha come scopo primario quello di riportare sulla terra campioni della superficie proprio della cometa Churymov-Gerasimenko (a questa missione è stato dato il nome di CAESAR). La scelta della cometa non e’ casuale. Rosetta ha effettuato uno studio dettagliatissimo di Churymov-Gerasimenko, lasciando una vera e propria legacy in termini di immagini ad altissima risoluzione e dati sull’ambiente cometario. Questa cometa è sicuramente quella meglio conosciuta, e quindi quella che minimizza i rischi inevitabili a cui vanno incontro missioni che hanno l’ambizione di posarsi su una cometa, prendere qualche sassolino, e poi ripartire alla volta della Terra. CAESAR per ora non e’ stata selezionata per la realizzazione dalla NASA, ma non è detto che non lo sarà in futuro. E’ un vero peccato che una missione simile non sia stata immaginata dall’ESA, come il naturale proseguimento del grande successo di Rosetta, su tempi scala magari più ravvicinati.

Prossima pubblicazione: 8 marzo 2020. 8. Ricerche che producono avanzamenti sostanziali verso ricerche incrementali

[1] The science of Interstellar, Kip Thorne, 2014 W W Norton & Co Inc

[2] Keck Array and BICEP2 Collaborations, arXiv:1810.05216v1

[3] Lee Smolin, Il mondo senza stringhe, 2006, Einaudi

[4] quando si dice altissima in questo caso è veramente altissima. Una densità paragonabile a quella dei nuclei atomici. Un cucchiaino di questa materia peserebbe quanto l’Himalaya.

[5] Fabrizio Capaccioni e collaboratori, 2015, Science, 347

[6] Kathrin Altwegg e collaboratori, 2016, Science

[7] Singularities, landmarks on the pathway of Life. Cambridge University Press 2005

[8] Phyl. Trans. Royal Soc. 2011