Dicembre 2019. Dopo molto tentennare mi decido a pubblicare queste pagine su un sito web e a pubblicizzare il sito sui tanto deprecati social. Compro un abbonamento per un dominio e supporto word press, e costruisco il sito www.lascienzainutile.it. L’idea è pubblicare tutto il libro a puntate, un capitolo a settimana. Assieme a una versione corta, stile blog, e se mi riesce anche una versione video.

22 febbraio 2020. Pubblico il Capito 7, che profeticamente si intitola Quale scienza è d’avvero utile? Il giorno prima i media sono pieni del primo caso autoctono di Covid-19. Il maratoneta di Codogno. E qui entriamo nella macchina del tempo, neanche fossimo novelli Dr. Emmett Brown.

In uno, due, cinque, dieci

giorni tutti (e quando dico tutti, intendo veramente TUTTI, un qualche miliardo

di esseri umani, essere più essere meno), siamo trasportati in un universo

parallelo. Ieri il mondo era il solito noioso, disordinato, ingiusto, rivoltante,

fantastico, assurdo, comprensibile e incomprensibile mondo. Oggi il mondo è

un’altra cosa. Che essendo altra, aliena, non posso quindi neanche azzardarmi a

descriverla. Sarebbe come se un essere tridimensionale (tipo uno qualsiasi di

noi, comuni mortali) cercasse di descrivere un oggetto quadridimensionale, o

pentadimensionale. Anche il più semplice oggetto quadridimensionale sarebbe

ultra-complicato da descrivere per noi comuni mortali in tre dimensioni. Così è

il mondo oggi, dopo un velocissimo, si potrebbe dire istantaneo, viaggio con la

più potente DeLorean che immaginazione abbia potuto concepire. Tutto quello che

davamo per scontato, scolpito nella roccia, le tasse, la partita di basket di

mio figlio alla quale assistere assieme ai genitori di altri scalmanati

ragazzi, lo spogliatoio del nuoto sempre di mio figlio, le intemperanze del

vicino guardone, il vucumpra’ che la domenica dopo pranzo si presenta

immancabilmente a suonare alla porta, quando l’unico desiderio del comune

mortale è quello di sprofondare su un letto o su un divano, per tentare di

digerire lo sformato e la salciccia arrostita sul carbone, tutto svanisce in

una nebiolina azzurrognola. Tutto svanito. La nuova realtà, il nuovo mondo non

so appunto descriverlo, so solo che è diverso. Per semplicità e per evitare di

usare le noiose perifrasi che ho appena usato, tipo nuova realtà, universo

parallelo, mondo nuovo, lo chiamerò “Arturo”.

Avrei potuto chiamarlo Priscilla, Genoveffa, Pincostrato, Ancomarzio,

Cappellaiomatto. Però ho la sensazione che a differenza del viaggio di Alice il

nostro sia un viaggio di sola andata. E poi Arturo

mi suona meglio.

Pubblico l’8 marzo il

Capitolo 8, che ancora più profeticamente è incentrato sul concetto di crescita

esponenziale. Cerco di spiegare cosa significa una crescita esponenziale, cosa

implica. Avevo scritto queste cose diversi mesi fa, e mai e poi mai avrei

potuto pensare che questo concetto, la crescita esponenziale, sarebbe stato alla base del mondo di Arturo in cui siamo stati trasportati dalla

DeLorean made in China. Ormai “esponenziale”

è la parola più usata da qualche miliardo di umani. Se dovessi incontrare

(metaforicamente parlando ovviamente, date le misure di contenimento sociale

attive nel mondo di Arturo) il mio

amico Dario, pescivendolo del paese, o il contadino Michele, da cui compro

pasciuti conigli e polli ruspanti, sono sicuro che queste semplici persone

potrebbero compitamente spiegarmi con esatta esattezza e dotta dottezza tutte

le implicazioni della crescita

esponenziale.

Decido di non scrivere e di

non pubblicare più niente, almeno fino a quando la crisi non sia passata, e la

DeLorean non ci abbia fatto tornare al 21 febbraio del mondo di prima. Anche

perché la maggior parte delle cose che ho scritto, incluso le pagine che precedono

e che seguono questo Intermezzo, le ho scritte viaggiando. In treno

soprattutto, ma anche in aereo. E le ho immaginate, pensate le pagine, i

concetti, mentre correvo. E non potendo più andarmene a correre per la campagna

né tantomeno viaggiare nel mondo di Arturo,

anche la vena creativa automaticamente si inaridisce.

Mi ci vogliono addirittura due settimane per capire la stupidità del pensiero precedente. Il viaggio nel futuro nel mondo di Arturo non prevede un ritorno. È stato un salto più che un viaggio, è stata una transizione di fase. Un’altra transizione di fase è certamente possibile, addirittura inevitabile (come è stata inevitabile quella provocata dalla DeLorean made in China), ma la nuova transizione di fase ci sposterebbe in un altro mondo, diciamo nel mondo di Amelia. E la probabilità che il mondo di Amelia sia anche solo simile al vecchio noioso, disordinato, ingiusto, rivoltante, fantastico, assurdo, comprensibile e incomprensibile mondo di ieri è sostanzialmente zero. Chi ha letto o visto la Guida Galattica per Autostoppisti [1] sa di che parlo. Una volta che avete premuto il pulzantone rosso che attiva il motore a improbabilità infinita, dio solo sa in che cosa sarete trasformati o in che mondo trasportati. Quindi se non c’è ritorno le cose sono due, o appendo penna e pensieri al chiodo e faccio solo lo spettatore (la conferenza stampa di Borrelli alle 18 confligge con i telefilm del Tenente Colombo su TopCrime, quindi registro queste puntate e le passo a conferenza stampa finita. Eccetto quando dopo Borrelli parla Conte. Il tutto per arrivare a sentire Zero Calcare su Propaganda Live e concludere con loro serata e settimana). Oppure trovo un’altra maniera altri magic-moment per pensare e per scrivere. Mica facile. Dopo aver preso cinque kili in una settimana (l’altro mio pallino è quello della cucina, e questa per fortuna non è scomparsa nel mondo di Arturo), decido di rispolverare la vecchia Cyclette ellittica. Bisogna dire che l’idea me la ha data mio figlio ottenne. Il quale per guardare in pace i suoi video su youtube senza essere continuamente ripreso, ha poggiato l’ipad sull’ellittica e dice: vado a fare esercizio! Come negargli esercizio quando non può essere più portato a nuoto/basket/calcetto? Quindi ho provato a vedere se anche il surrogato mi fornisce un magic-moment per pensare. Alla terza seduta qualche barlume di idea si è affacciata nella mia mente. È stata una piacevole sorpresa, dopo un mese passato in stato catatonico nel mondo di Arturo.

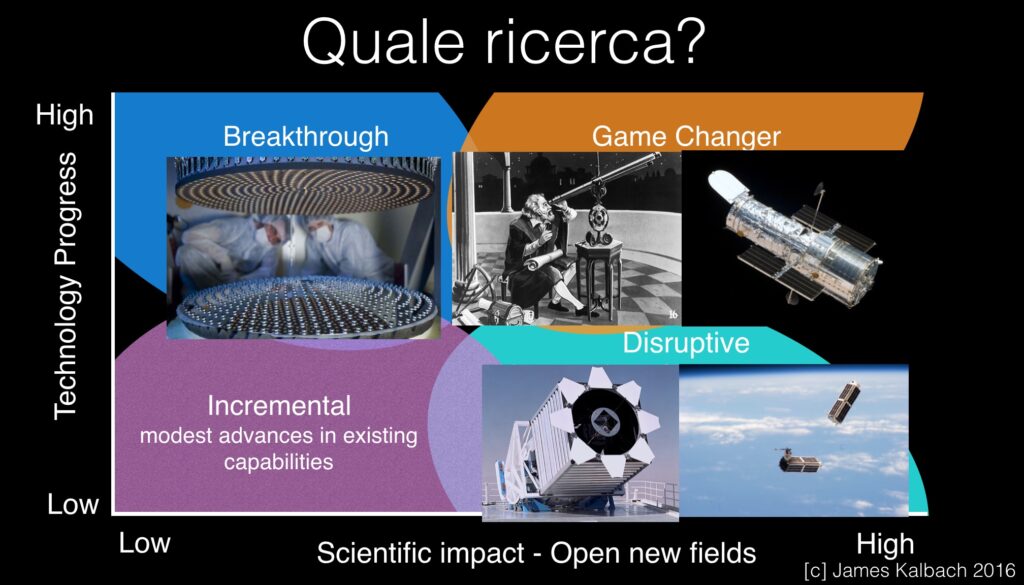

Pensiero n. 1: Il viaggio

nel mondo di Arturo è di sola andata,

perché è una transizione di fase (e questo lo ho già detto, non voglio

ripetermi).

Pensiero n. 2: La nuova

normalità non sarà tanto normale se confrontata col mondo di ieri.

Pensiero n. 3: Durante la precedente transizione di fase una ottantina di anni fa, la differenza la fecero le intuizioni di alcuni scienziati, di alcuni imprenditori e di alcuni politici, come ho raccontato brevemente nei capitoli precedenti. Ad esempio la creazione dell’OSRD da parte di Franklin Delano Roosevelt, su suggerimento di Vannevar Bush, la creazione della National Science Foundation da parte di Harry Truman, sempre su suggerimento di Vannevar Bush, la creazione dell’ARPA, poi DARPA, e via dicendo, tutte strutture volte a massimizzare la creazione di innovazioni fondamentali. Le parole scritte da Bush nel 1945 sono quanto mai attuali: “I progressi nella guerra contro le malattie dipendono dal flusso di nuove conoscenze scientifiche”. È ovvio che la differenza nell’odierna transizione di fase la può fare la scoperta di una cura per il Covid-19 e/o un vaccino. Come si arriva a queste scoperte nel minor tempo possibile? Probabilmente queste sono vere e proprie missioni incredibili[2]. Terminavo giusto il capitolo 8 chiedendoci se l’organizzazione delle nostre Università e istituti di ricerca è tale da massimizzare le missioni incredibili. Facendo un po’ di spoileraggio alle conclusioni che avrei presentato nelle prossime settimane, il mio personale parere è che nella maggior parte dei casi l’organizzazione delle nostre Università e Istituti di ricerca non è quella ottimale per massimizzare la produzione di missioni incredibili. E non sarà facile cambiare il DNA di quelle Università e Istituti di ricerca, che oggi non sembrano tanto favorire una risposta creativa/immediata/completa a un problema complicato. Quale è la situazione della Big Pharma non lo posso dire con precisione, non lavorando nel settore. Mi sembrano però ragionevoli i concetti presentati da Safi Bahcall, che invece lavora nel settore sanitario negli Stati Uniti, secondo il quale le organizzazioni più agili, piccole e motivate sono quelle meglio attrezzate per produrre missioni incredibili. È possibile seguire l’esempio di 80 anni fa? Creando ex-novo una organizzazione fatta apposta per risolvere in poco tempo e con grande efficienza problemi complicati? In quel caso il processo fu top-down. La decisione di un Presidente illuminato (FDR) che ha seguito il consiglio di scienziati illuminati, motivati e senza paura di mettere sul tavolo soluzioni forti, impopolari (i generali di ogni grado, genere e tipo non furono sulle prime entusiasti di vedere stra-finanziata ricerca per nuovi sistemi d’arma o di comunicazione o di intelligence da parte di pivelli civili). Il paragone con il mondo di Arturo (o con il mondo di ieri) mette paura. FDR verso The Donald. Accanto al quale si vede spesso il Dr. Anthony Fauci, direttore del National Institute of Allergy and Infectious Diseases, che rispondendo ai giornalisti che gli chiedevano dei marchiani errori di Trump durante le conferenze stampa afferma: “non posso saltare davanti al microfono e sbatterlo via, cerco invece di correggerlo per la prossima conferenza stampa”[3]. Il che può ancora andare bene nel mondo di ieri, ma nel mondo di Arturo dove tutto si muove con una velocità ipersonica, potrebbe non esserci una prossima conferenza stampa.

Pensiero

n. 4: Può essere efficiente un processo dal basso, o almeno da un qualche lato,

per produrre le missioni incredibili

che ci servono subito? Le soluzioni potrebbero assomigliare a quelle discusse

nel Capitolo 6: Spazio (4.0), l’ultima frontiera. Ovvero: imprenditori

illuminati, start-up innovative e i cinesi.

Pensiero n. 5: Questa in realtà non è una nuova idea. Sono diversi anni che ci giro attorno e che ne parlo anche durante le mie conferenze. Il mondo di Arturo però rende il concetto talmente chiaro che non c’è bisogno di sprecare troppo pensare o troppe parole: i virus non conoscono le frontiere. Non conoscono quelle fra Stati, ma tanto meno quelle tra le regioni o città. La risposta a una “pan”demia per definizione non può essere locale, deve essere globale. Le politiche (sanitarie, economiche, sociali) da mettere in campo contro una “pan”demia per essere efficaci devono essere condivise globalmente, non hanno senso se portate avanti da qualcuno si mentre qualcun altro non le segue. Ci sono due livelli fondamentali nella ideazione e nella applicazione delle politiche (sanitarie, economiche, sociali): il livello governativo, che deve ideare, programmare e valutare le conseguenze di queste politiche (con il supporto fondamentale della scienza), e il livello delle comunità, le famiglie, gli ospedali, i paesi, le città, che queste politiche devono poi metterle in pratica. In mezzo, soprattutto in Germania, ma anche in Italia, c’è un livello burocratico la cui funzione nel mondo di Arturo non è che sia chiarissima. La risposta al Covid-19 può essere differente in Calabria piuttosto che in Lombardia? Il distanziamento sociale a Caltanissetta è diverso da quello di Bergamo? I ventilatori polmonari e le famigerate mascherine che servono a Venezia sono differenti da quelle che servono a Bari? O di Grenoble, o di Bruxelles, o di Budapest? Quale è il senso di una politica sanitaria lucana e di una friulana? Nel mondo di Arturo aumenta l’importanza del livello governativo, e soprattutto delle comunità. Diminuisce l’importanza del livello burocratico intermedio, quello delle Regioni. Il mondo di Arturo è allo stesso tempo più globale e più locale. Il che è bizzarro ma interessante. “Io” posso fare la differenza, se me ne sto a casa, non mi infetto e non infetto nessuno. Il mio sindaco, o il Direttore del mio ospedale può fare la differenza, non solo per quello che riguarda il mio paese o il mio ospedale, ma anche per quello che riguarda l’aspetto globale. Se ci si pensa un attimo la stessa cosa si applica ad altri pericoli e quindi altre sfide globali, come quella del degradamento del nostro ambiente e della transizione ecologica. Una connessione messa in evidenza anche dal direttore dell’ESA Jan Worner[4].

Pensiero n. 6: Se il mondo di Arturo è più globale del mondo di prima ne segue che acquistano più importanza anche le istituzioni più grandi. L’Unione Europea, per quello che concerne noi Italiani, o le Nazioni Unite. Nel mondo di Arturo una politica economica per l’emergenza, e poi durante la ricostruzione, non sembra possa essere efficace se attuata solamente in Italia, piuttosto che in Spagna o in Danimarca. Una politica economica diventa efficace se è condivisa dal mercato unico, cioè da tutta l’Unione Europea. Ma quale Unione Europea? L’Unione Europea del mondo di ieri aveva un bilancio di circa 1% del PIL Europeo. Le politiche economiche per l’emergenza e la ricostruzione dovranno mobilitare somme forse 10 volte maggiori. E immaginare politiche economiche efficaci e poi attuarle non sembra facile per un organismo burocratico come la UE del mondo di ieri (tre istituzioni, l’Europarlamento, il Consiglio Europeo e la Commissione Europea, spesso in conflitto/contraddizione uno con l’altra, più la Banca Centrale Europea che è una istituzione indipendente, e quindi non sotto il controllo politico di una delle tre istituzioni che formano l’UE). Una UE che sia in grado di ideare e poi applicare una politica economica globale è certamente una cosa da inventare nel mondo di Arturo. Una istituzione probabilmente vicina a quella immaginata da Gael Giraud[5]. Quella “Con”federazione, forse pure nei sogni dei padri fondatori dell’Europa, che sia capace di gestire in maniera efficiente i beni comuni Europei, il lavoro, l’ambiente e la moneta. E che come auspica Gael Giraud possa poi guidare laTransizione Ecologica.

Pensiero

n. 7: Una delle particolarità più disturbanti del mondo di ieri era il costante

aumento nel tempo delle disparità sociali, almeno nella parte occidentale di

questo mondo. Nel Capitolo 2 avevo mostrato come neanche l’innovazione sembrava

essere capace a favorire la riduzione delle ineguaglianze verticali, a mio

parere uno dei motivi per i quali nel mondo di ieri la scienza non aveva

decisamente una buona pubblicità. Nel mondo di Arturo c’è il rischio che le ineguaglianze, sia quelle verticali

che quelle orizzontali aumentino ulteriormente, e che esplodano in una crescita

anche questa esponenziale. Ma esiste anche l’opportunità per la scienza di

favorire la riduzione di queste disparità. La scoperta di una cura e/o un

vaccino per il Covid-19 tenterebbe chiaramente a ridurre le ineguaglianze sia

verticali che orizzontali, a patto che poi queste cure siano disponibili per

tutti. Basti pensare che il pericolo di vita per le persone anziane è almeno un

ordine di grandezza maggiore che per i giovani e che le persone che sono

maggiormente colpite accanto agli anziani, sono gli invisibili. I precari e tutta la enorme massa di persone che vive

di lavoro nero. Diversi Paesi stanno mettendo in campo misure dedicate agli invisibili. Misure come ad esempio in

Italia il reddito di emergenza.

L’auspicio è quello che oltre a curare l’attuale emergenza, questo reddito sia utile anche per far emergere almeno una parte degli invisibili, facendoli partecipare

pienamente ed apertamente allo sviluppo della società. Questo sarebbe uno

straordinario successo, che sì contribuirebbe in maniera sostanziale a

diminuire le ineguaglianze.

Pensiero

n. 8: Al contrario di quello che succedeva nel mondo di ieri, nel mondo di Arturo la scienza è popolare. Il

problema ora per noi scienziati è quello di non dilapidare questa attestazione

di fiducia. Una responsabilità aggiuntiva.

[1]

Douglas Adams, Guida Galattica per gli Autostoppisti. Mondadori

[2] Safi Bahcall, Idee folli, 2019 ROI Edizioni

[3] https://www.sciencemag.org/news/2020/03/i-m-going-keep-pushing-anthony-fauci-tries-make-white-house-listen-facts-pandemic

[4] https://spacenews.com/commentary-space-and-coronavirusany-connection/

[5] Gael Giraud, Transizione Ecologica, 2015, EMI